重複コンテンツとは、タイトルやテキストが他のコンテンツと重複している状態を指します。

昨今のGoogleのアルゴリズムは「高品質なコンテンツ」を重要視しているため、他のページをコピーしたようなコンテンツがWebサイトやブログ内に存在していると、SEOでマイナスの評価を受けてしまいます。そのため、コンテンツが重複しないようにあらかじめ対処をして、SEO評価が下がるリスクを回避することが重要です。

とはいえ、「そもそもサイト内に重複コンテンツが存在しているかわからない」という方もいるのではないでしょうか。

本記事では、重複コンテンツの調べ方や対処法、SEO対策で重複コンテンツを避けるべき理由について解説します。

「重複コンテンツの調べ方がわからない」

「重複コンテンツが存在している場合の対処法を教えてほしい」

このような疑問・要望がある方はぜひ最後までご覧ください。

1『SEOコンサルティング』:サイト全体の戦略設計からプロが伴走

2『SEO内製化支援プラン』:正しいSEOの知識で内製化を実現

3『Webコンサルティング』:サイト改善によるCV創出で成果最大化

\「SEO」で1位の弊社が研究し尽くしたSEO×AI活用ノウハウを無料配布!/

重複コンテンツとは?

重複コンテンツとは、サイト内外問わずコンテンツ内容が他のページと重複している状態を指します。

Google公式では、重複コンテンツのことを以下のように定義しています。

一般に、重複するコンテンツとは、ドメイン内または複数ドメインにまたがって存在する、同じ言語の他のコンテンツと完全に同じであるか非常によく似たコンテンツのブロックを指します。

引用:Googleセントラル 上級者向けSEO 重複コンテンツを避ける

サイト内に同様のコンテンツがある

重複コンテンツは、「wwwの有無」や「自動生成ページ」など、Webサイトの仕様上の問題によって生じる場合があります。

そのため、自社でも気づかないうちに重複コンテンツを発生させてしまい、意図しない形でSEO評価を下げている可能性があるのです。

ただし、サイト内に重複コンテンツが発生している場合は、後述で解説する対処法で重複を防げます。本記事を読んで重複コンテンツに該当している場合は、対処法を実践してみましょう。

他サイトで同様のコンテンツがある

自サイト内だけでなく、他サイトのコンテンツの盗用や無断コピー、類似によって、重複コンテンツが生じる場合もあります。

たとえ許可を取ってコンテンツを転載していたとしても、然るべき処理をしていなければ、Googleから重複コンテンツとして判断されます。

コンテンツ制作者は、引用元を明記したり、ツールを使うなどして、他コンテンツと重複していないか注意するようにしましょう。

SEO対策において重複コンテンツを避けるべき理由

重複コンテンツは、SEO評価に大きな影響を及ぼします。

ではなぜ、重複コンテンツは避けた方が良いと言われるのでしょうか。

SEO対策において重複コンテンツを避けるべき理由は3つあります。

- 被リンク評価が分散する

- 検索結果画面に表示されなくなる

- ペナルティ対象になる

それぞれ詳しく解説します。

\7,700社支援・「SEO対策」で1位を獲得したノウハウを無料で伝授!

/

被リンクの評価が分散する

1つ目の重複コンテンツを避けるべき理由は、「被リンクの評価が分散する」からです。

内容が重複したページが別のURLで存在している場合、そのページに対して集まっている被リンクの効果が分散し、適切な評価を得られない恐れがあります。例えば、本来被リンクの評価が100点受けられるはずだったのに、重複コンテンツによって被リンクが分散され50点の評価になるようなイメージです。

このような評価の分散は、Google側で対処してくれる場合もありますが必ずしもそうとは限らないため、自社で適切な評価を受けられるように対策する必要があります。

被リンクによるSEO効果についてより詳しく知りたい方は、下記の記事もご覧ください。

検索結果画面に表示されなくなる

2つ目の重複コンテンツを避けるべき理由は、「検索結果画面に表示されなくなる」からです。

Googleの検索エンジンは、独自のアルゴリズムによって、様々なページをバランスよく検索結果上に表示させています。

しかし、検索結果が同じ内容のコンテンツばかりだと、多様化しているユーザーのニーズには応えられず、Googleの利便性が低下してしまいます。そうなると利用ユーザーの満足度低下にもつながるため、Google側からするとなんとしても避けたいところでしょう。

そのため、重複・類似コンテンツは、クロールやインデックスされる可能性が減ってしまい、検索結果画面に表示されなくなるのです。

つまりGoogleは、「重複コンテンツを検索結果に表示させるぐらいなら、他のコンテンツを表示させた方が良い」と判断しています。

ペナルティ対象になる

最後の重複コンテンツを避けるべき理由は、「ペナルティの対象になる」からです。

「無断でコピーされたコンテンツ」は、Googleから重複コンテンツと判断され、ペナルティの対象になります。

ペナルティの対象になるのは以下の場合なので、下記の基準を満たしているサイトがないか確認しましょう。

- 他のサイトのコンテンツをコピーし、独自のコンテンツや付加価値を加えることなく転載しているサイト

- 他のサイトのコンテンツをコピーし、(語句を類義語に置き換えたり自動化された手法を使用したりして)若干の修正を加えた上で転載しているサイト

- 何らかの独自の体系付けやユーザーへの利便性を提供することなく他のサイトからのコンテンツ フィードをそのまま掲載しているサイト

- ユーザーに実質的な付加価値を提供することなく、他のサイトの動画、画像、その他のメディアなどのコンテンツを埋め込んだだけのサイト

引用:Googleセントラル 上級者向けSEO 無断複製されたコンテンツ

今のGoogleのアルゴリズムでは、コンテンツの質が最重要視されています。しかしながら順位操作を目的として、他サイトのコンテンツを盗用したり、サイト内のコンテンツ数を増やすために同じまたは似たコンテンツを複数作成したりする行為が増えているのも事実です。

それではGoogleのアルゴリズムに反していることになるので、悪質なサイトと判断され、ペナルティの対象となる場合があるのです。

過度でない限りすぐにペナルティ対象にはなりづらいものの、事前に対策しておくことでそのリスクを軽減できます。

いづれにしても、ペナルティの対象にならないようにコンテンツを制作するのが賢明です。

重複コンテンツの調査方法

重複コンテンツを調べる方法は2つあります。

- ①実際に検索する

- ②ツールを活用する

それぞれのチェック方法を詳しく解説しますので、実際に重複していないか確認してみましょう。

①実際に検索する

重複コンテンツの対象ページの検討が付いている場合は、実際に検索するのが最も手軽な方法です。

重複コンテンツに該当していそうなページのコンテンツの一部をコピーし、検索窓に打ち込むと、コピーしたコンテンツと一致するページが検索結果に表示されます。

用語説明など、どのサイトも内容が似通っている部分の類似ならさておき、フレーズや表現といった点まで一致している場合は、重複コンテンツと認識される可能性が高いです。

もし実際に検索してみて、重複コンテンツと判断できるようであれば、後述する対処法を試してみましょう。

②ツールを活用する

重複チェックツールを活用すると、重複コンテンツを効率的に調査できます。

本記事では2つのツールを紹介します。

- sujiko.jp

- Google Search Console(サーチコンソール)

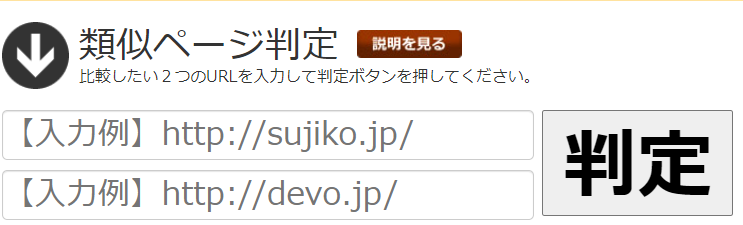

sujiko.jp

sujiko.jpは、入力した2つのページの類似度を判定できる無料ツールです。

URLを入力して「判定ボタン」をクリックするだけで、該当ページが重複コンテンツなのかどうか判断してくれます。

sujiko.jpの判定基準は4つあります。

- タイトル類似度

- 本文類似度

- HTML類似度

- canonical指定

また、自サイトだけでなく、他サイトのコンテンツとの類似度もチェックできます。うまく活用して、重複コンテンツをチェックしてみましょう。

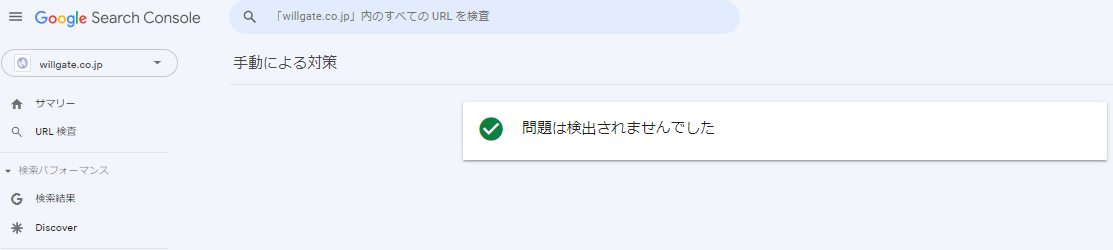

Google Search Console(サーチコンソール)

重複コンテンツは、Google Search Console(サーチコンソール)でも調査できます。

Google Search Console(サーチコンソール)の画面を開きます。

左メニューから「セキュリティと手動による対策」→「手動による対策」の順にクリックし、「問題は検出されませんでした」と表示されれば重複コンテンツはありません。

▼エラーがなかった場合

一方でエラーと表示されるようであれば、重複コンテンツが存在している可能性があります。その場合は、次の章で解説する対処法を試してみましょう。

重複コンテンツの対処法

調査した結果、重複コンテンツが見つかった場合は、然るべき対応をする必要があります。

この章では、重複コンテンツの対処法を7つ解説します。

- 301リダイレクト処理

- canonicalタグの設置

- noindexタグの設置

- URLパラメータ設定

- コンテンツの非公開または削除

- Googleにコンテンツを削除養成

- 【注意点】robots.txtの設定

301リダイレクト処理

301リダイレクトとは、ステータスコードの1つで、URLが恒久的に変更される際に利用する転送処理のことです。

主に、ドメイン変更やサイト移転、URLの正規化などの用途で使われます。

wwwの有無であればコンテンツの内容は同じであるものの、URLが異なる場合は、301リダイレクト処理を行いURLを統一することで、検索エンジンからの評価を1つのURLに集約できます。

301リダイレクトについてより詳しく知りたい方は、下記の記事もご覧ください。

301リダイレクトとは?行うべき理由や設定方法、注意点を徹底解説

canonicalタグの設置

canonicalタグは、Webサイト内でコンテンツが重複している、もしくは極めて内容が似ているURLが複数存在する場合に、1番評価してほしいURLを検索エンジンに示すために用いるタグです。

サイト運営には、やむ得ない理由で重複・類似コンテンツが発生する場合があるため、canonicalタグを用いてGoogleから評価されるページを1つに統一し、SEO評価が分散するのを防ぐ必要があります。

canonicalタグをHTMLで記載する場合、headタグ内に下記のように記述します。

<link rel=”canonical” href=”評価を集中させたいページのURLを記述”>

例えば、外部サイト内に転載の許可を出して、同じコンテンツを掲載している場合、外部ページから自ページに向けてcanonicalのURLを指定してもらい自ページを正規URLだと認識させる対応を依頼することで、評価されるページを統一できます。

もし仮に外部サイトがcanonical指定していない場合は、どちらかのページがペナルティとなる可能性があります。「自ページだからペナルティにならない」とは限らないため、外部サイト内に転載許可を出すときは、必ず自サイトに向けてcanonicalを指定してもらうようにしましょう。

canonicalタグについてより詳しく知りたい方は、下記の記事もご覧ください。

canonical(カノニカル)タグとは?SEOの関係性やURL正規化の定義を解説

noindexタグの設置

metaタグの1つであるnoindexタグを設置することで、検索エンジンからのインデックスを拒否することができます。

つまり、重複しているコンテンツ自体を存在しない扱いにできるのです。

とはいえ、せっかく制作したコンテンツのインデックスを拒否するのは勿体無いので、なるべくcanonicalタグで重複を解消することをおすすめします。

外部サイト内に転載の許可を出して同じコンテンツを掲載している場合、外部ページから自ページに向けてnoindexタグを指定してもらうように依頼することで、外部サイトに掲載しているコンテンツがインデックス登録されるのを防ぐことができます。

noindexについてより詳しく知りたい方は、下記の記事もご覧ください。

noindexタグとは?SEO効果や設定方法、注意点について解説

URLパラメータ設定

Google Search Console(サーチコンソール)の「URLパラメータ」機能を活用すれば、パラメータを含むURLのうち、どのURLを評価対象にするかを決めることができます。つまり、このURLパラメータ設定によって、検索エンジンのクローラーの制御ができるのです。

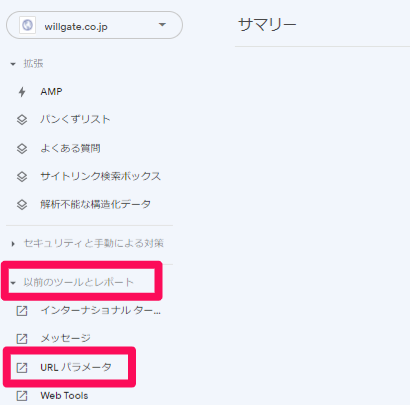

URLパラメータの設定は、Google Search Console(サーチコンソール)画面の左にあるバーから「以前のツールとレポート」→「URLパラメータ」で設定できます。

例えば、ECサイトの商品一覧ページなど、URLパラメータのみが異なる場合や類似したページが同一サイト内に大量に発生する場合に、URLパラメータを設定しておくのも1つの手です。

ただし、設定ミスによって、本来クロールしてほしいページがクロールされなくなるなどのリスクも考えられます。そのため、URLパラメータ設定はSEO有識者におすすめの方法と言えるでしょう。

コンテンツの非公開または削除

自サイト内に重複コンテンツがある場合は、片方を非公開または削除処理するのも1つの手段です。

また、自サイトではなく外部サイト内に重複コンテンツが存在しており、それが自社で意図していない形の重複コンテンツの場合は、外部サイトの担当者に連絡して以下の対処をしてもらう必要があります。

- 対象コンテンツを非公開

- 対象コンテンツの削除

例によっては外部サイトの担当者に連絡しても対処してもらえないこともあります。そういった場合は、後述で解説する「Googleにコンテンツを削除要請」を試してみてください。

Googleにコンテンツを削除要請

外部サイトが許可なくコンテンツを使用しているのにも関わらず、canonicalタグやnoindexタグなどの設定をしていない場合があります。

そのような場合は、自ページとコンテンツが重複しないよう対処してもらう必要がありますが、先方が申し出に応じない可能性もあり得ます。

もし問い合わせて対処してもらえないようであれば、「著作権侵害による削除」から、Googleにコンテンツの削除申請を出してみましょう。Googleが著作権を侵害していると判断すれば、該当のページは削除され、コンテンツの重複は解消されます。

【注意点】robots.txtの設定

robots.txtの設定で重複コンテンツを解消する方法もあります。

noindexがインデックスを拒否する一方で、robots.txtはクローラーを拒否します。

ただし、robots.txtを設定してクローラーを拒否することは、Googleが推奨していない設定なので注意しましょう。

以下はGoogle公式から発表されている見解です。

「Google は、ウェブサイト上の重複コンテンツに対するクローラ アクセスを禁止することは、robots.txt ファイルかその他の手段かにかかわらず、おすすめしていません。重複コンテンツを含むページをクロールできないと検索エンジンではそれらの URL が同じコンテンツを指していることを自動検出できないため、このような URL を独立した個別のページとして効率的に処理する必要があります。」

引用:Googleセントラル 上級者向けSEO 重複コンテンツの作成を避ける

robots.txtについてより詳しく知りたい方は、下記の記事もご覧ください。

robots.txtとは?意味やSEO効果、設定方法を徹底解説

まとめ

本記事では、重複コンテンツの調査方法や対処法、SEO対策で重複コンテンツを避けるべき理由について解説しました。

重複コンテンツとは、同一ドメイン内またはサブドメインにまたがって存在し、サイト内外問わず他のページと酷似しているコンテンツのことです。重複コンテンツがサイト内に存在していると、被リンクの評価が分散したり、ペナルティの対象になるなど、SEO評価でマイナスの影響を及ぼします。

そのため、自サイトで重複コンテンツを発見した場合は、本記事で解説した対処法を参考にして適切に対処するようにしましょう。

資料ダウンロード

資料ダウンロード SEO無料相談

SEO無料相談